1、MCP介绍

MCP的全称是Model Context Protocal(模型上下文协议),是AI公司Anthropic(开发Claude的公司)在2024年11月提出并开源的。它是一种开放标准协议,目的在于解决大型语言模型(LLM)和外部数据源、工具直接的通信问题。

简单来说,MCP为AI模型与外界资源(如数据库、API、设备等)建立了一种【通用语言】或【万能插座】,让AI能够像人类一样调用工具、获取信息并执行任务。

1.1、MCP的起源

能调用外部工具,是大模型成为智能体的关键,如果不能使用外部工具,那么大模型只能进行简单的聊天或者基于已有的训练进行信息处理,无法做到实时信息处理。

因此大模型采取了Function call的思路,创建一个外部函数作为中介,以便传递大模型的请求,另外以便调用工具,这样就让大模型具备了获取外部信息的能力。

MCP统一了Function call的运行规范,从下午可以直观的看出差距。

1.2、MCP的作用

- AI领域的USB-C接口

就像USB Type-C统一了设备连接方式,成为一种通用的接口外形标准,MCP也让AI大模型与外部系统之间有了一套交互的标准。

- 从【被动应答】到【主动执行】

传统LLM只能生成内容,而通过MCP,AI大模型就可以调用工具(如发送邮件、查询数据),成为能直接“动手做事”的智能体(AI Agent)。

1.3、MCP的架构与组件

MCP采用了【客户端-服务器】架构,其中包含三个核心角色:

1.3.1、MCP主机(Host)

对外发起请求的运行AI应用或平台,比如Claude、IDE、聊天界面,主机内部集成了MCP客户端,主要负责处理和转发请求。

1.3.2、MCP客户端(Client)

内嵌于主机中,负责按照MCP协议和外部的MCP服务器建立连接,将主机的请求打包后发送给对应的服务器,并且接受服务器的响应再传回主机,从而解析请求并与服务器通信。

1.3.3、MCP服务器(Server)

部署在资源侧的程序,按照MCP协议标准接受客户端的请求,并且执行操作后将最终结果以标准化格式返回给客户端,主要给客户端提供工具、资源和提示。

2、Cherry Studio安装配置、Cherry Studio接入大模型、Cherry Studio调用MCP工具

2.1、Cherry Studio安装配置

2.1.1、安装nodejs

官网地址:https://nodejs.org/en/download

2.1.2、安装cherry studio

官网地址:https://www.cherry-ai.com/download

2.2、Cherry Studio接入大模型

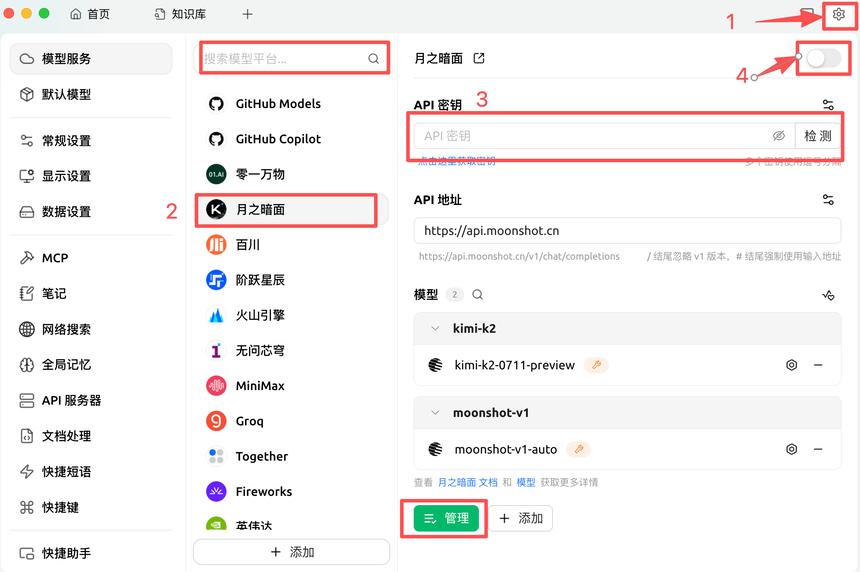

2.2.1、在设置页面添加大模型

2.2.2、在对话窗口选择切换大模型按钮

2.2.3、在弹框中选择想要的模型

2.3、Cherry Studio调用MCP工具

2.3.1、在魔塔社区官网的MCP广场搜索需要的MCP工具

魔塔社区MCP广场地址:https://www.modelscope.cn/mcp

2.3.2、复制合适的接入方式代码

Remote方式最简单,但是貌似要经过魔塔中转一次,容易受限。

2.3.3、在Cherry Studio设置中添加MCP工具

粘贴魔塔中复制的JSON代码

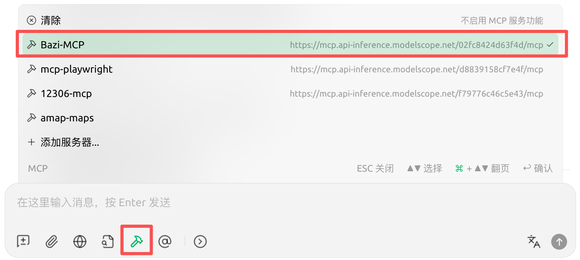

2.3.4、在对话框中选中需要的MCP工具

如果问题需要调用MCP工具解决,则会自动调用MCP工具执行,也可以手动指明要求使用指定的MCP工具回答。

3、使用Ollama搭建本地大模型并调用

时间来到了下午的4点10分,终于到了这一步,学习这套课程最想学的就是这个,终于有了嵌入模型的应用,也和《跟着企业级大模型开发部署方案来学习大模型》上面的内容对应起来了。

3.1、ollama下载安装

ollama官网:https://ollama.com/

从跟着企业级大模型部署方案那篇我们知道了,Ollama专注于大模型语言(LLM)的本地部署与管理。文章说,对于嵌入模型,ollama平台比较少,但是还是有,对于重排序模型,ollama平台上几乎没有。

3.2、下载嵌入模型

使用如下命令下载Qwen-embedding嵌入模型:

ollama run modelscope.cn/Qwen/Qwen3-Embedding-0.6B-GGUF:Q8_0上面这个命令是老师发的,下载的是魔塔社区的模型,使用的是run命令,使用ollama的run命令时,当ollama发现没有此模型时,会下载模型,然后运行。

下面这个命令是自己总结的,下载的是ollama官方平台的qwen嵌入模型:

ollama pull qwen3-embedding:0.6b这里有些同学会模型下载不成功的问题,原因是他们的ollama是在第三方网站下载的,不是最新版,去官方下载最新版ollama安装运行,然后再去下载嵌入模型即可。

3.3、在cherry studio创建知识库,并调用

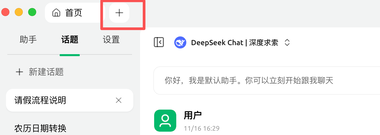

3.3.1、点击首页旁边的+号打开应用面板

3.3.2、打开知识库

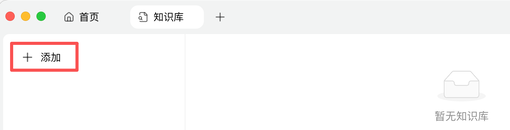

3.3.3、点击添加按钮新增一个知识库

3.3.4、添加知识库

3.3.5、上传文档到知识库

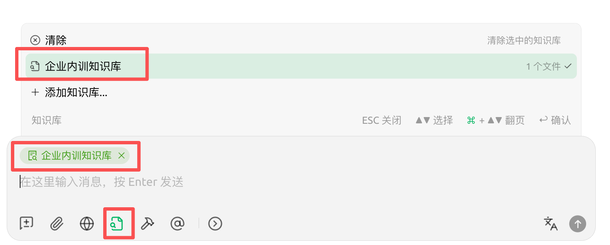

3.3.6、在对话框选中刚刚添加的知识库

3.3.7、搜索请假流程,会发现大模型会调用刚刚创建的知识库

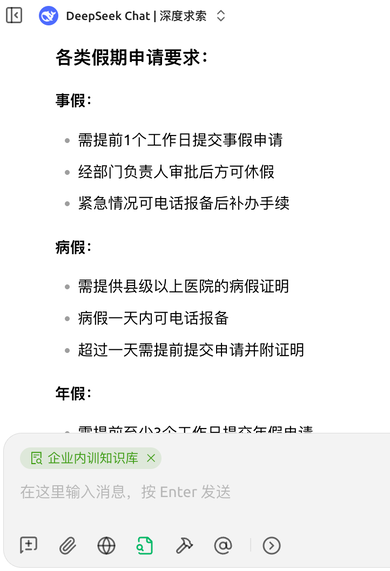

3.3.8、回答内容示例,是从刚刚上传的docx文件中整理出来的

今日小结

终于初次体验到了本地大模型的威力,以及知识库相关的内容,还有嵌入模型、重排序模型等,终于和之前看到的内容对应起来啦。